DeepSeek AI 是开源语言模型领域的重大进步。它提供强大的分析功能——无需专门的 GPU 硬件。结合精益模型管理工具Ollama,创建了一种高效的解决方案,可以在本地运行AI模型,同时最佳地控制数据保护和性能。

为什么要自己托管 DeepSeek?

如果您在自己的 jtti 服务器上运行 DeepSeek,您将受益于更高的隐私和安全性。这一点尤为重要,因为安全研究人员最近发现了一个不受保护的 DeepSeek 数据库,其中包含聊天记录、API 密钥和后端详细信息等敏感数据。

通过自托管,所有信息都保留在您自己的基础设施中。这可以帮助您避免安全风险,同时确保您的环境符合 GDPR 和 HIPAA 标准。

革命性的基于 CPU 的性能

DeepSeek 模型在基于 CPU 的系统上高效运行——无需昂贵的 GPU 硬件。这使得更多用户可以享用先进的人工智能。无论您使用 1.5b 还是 14b 模型,DeepSeek 都能在常见的服务器配置(包括虚拟专用服务器 (VPS))上可靠地运行。

本地控制和最大灵活性

通过自托管,您可以完全访问 API 并完全控制模型设置。这使您可以自定义 DeepSeek,优化安全措施,并将其无缝集成到您现有的系统中。

由于开源,DeepSeek 提供了完全的透明度并使社区能够不断改进。这使得它成为任何重视性能和数据保护的人的完美选择。

jtti 上的 DeepSeek:分步安装

系统要求

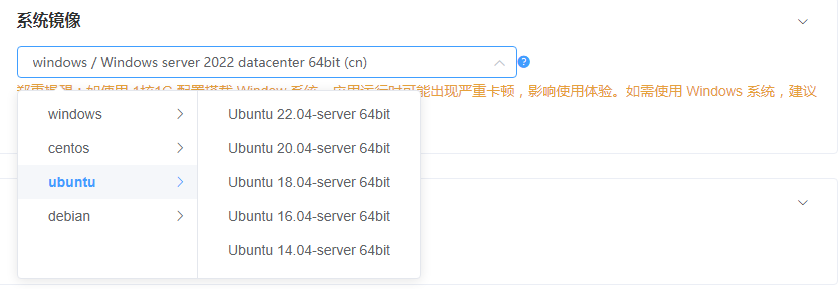

在您的 jtti 服务器上安装 DeepSeek 之前,请确保您的系统上正在运行 Ubuntu 22.04 LTS。

注意:我们建议使用我们的VDS M-XXL 型号,因为它们提供实现最佳性能所需的资源。功能较低的计划可能会有效,但它们肯定会影响 LLM 的性能。

独家:jtti 预配置的 DeepSeek 图像

jtti 作为第一个也是唯一一个提供预配置 DeepSeek 图像的 VPS 提供商树立了新的标准。这消除了复杂的设置过程,您可以在几分钟内开始使用。

我们预先配置的图像可确保最佳性能设置和随时可用的环境。

要在服务器设置期间选择预配置的 DeepSeek 图像:

1、转到产品配置器中的步骤 4“图像”

2、从可用选项中选择 DeepSeek 图像

3、继续服务器配置

有了这个预配置的图像,您可以立即开始使用,并且仍然有足够的自由来进一步测试和优化模型的性能。一旦您的服务器部署完毕,您就可以立即使用 DeepSeek – 无需任何额外的安装。

手动安装

如果您喜欢自定义设置,您可以手动安装 DeepSeek。该过程很简单,但需要几个步骤。以下是说明:

为了使 DeepSeek 顺利运行,您的 jtti 服务器必须运行Ubuntu 22.04 LTS。

首先,确保您的系统是最新的:

sudo apt update && apt upgrade –y接下来,您可以安装 Ollama。 Ollama 是一个轻量级模型管理工具,用于处理 DeepSeek 部署过程:

curl -fsSL https://ollama.com/install.sh | sh安装后,您需要启动 Ollama 服务来部署您的模型:

sudo systemctl start ollama现在您可以检索所需的 DeepSeek 模型。14b 版本在性能和资源使用之间实现了极好的平衡:

ollama pull deepseek-r1:14b下载完成后,您的服务器就可以使用 DeepSeek AI 了。

模型部署

安装后,即可直接使用DeepSeek。直接运行模型以交互方式使用它:

ollama run deepseek-r1:14b如果您想将 DeepSeek 集成到您的应用程序中,请启动 API 服务:

ollama serve检查安装

通过执行以下检查确保所有内容均已正确安装:

ollama list

ollama run deepseek-r1:14b "Hallo, bitte überprüfe, ob du korrekt arbeitest."如果这些测试成功,您的 DeepSeek 设置就准备好了!

模型兼容性和系统要求

模型尺寸概览

DeepSeek 提供针对不同需求的不同尺寸的模型:

| 模型版本 | 尺寸 | 所需 RAM | 推荐方案 | 应用领域 |

| deepseek-r1:1.5b | 1.1 GB | 4GB | 电压差分信号 | 基本任务,在标准笔记本电脑上运行,非常适合测试和原型设计 |

| deepseek-r1:7b | 4.7 GB | 10 GB | 电压差分信号 | 文字处理、编码、翻译 |

| deepseek-r1:14b | 9 GB | 20 GB | 电压差分 | 强大的编码、翻译和文案撰写功能 |

| deepseek-r1:32b | 19 GB | 40 GB | 威盛 | 达到或超过 OpenAI 的 o1 mini,非常适合高级分析 |

| deepseek-r1:70b | 42 GB | 85 GB | 超大尺寸 | 对于企业应用程序、复杂计算和高级 AI 分析 |

根据您的要求,您可以为 Contabo 上的 AI 托管选择合适的模型。

资源分配技巧

高效的内存管理对于实现最佳性能至关重要。始终提供两倍于模型大小的 RAM 以确保顺利运行。例如,14b 模型(9 GB)在20 GB RAM下运行效果最佳,可实现高效的模型加载和处理。

关于存储,NVMe 驱动器是加快模型加载时间的最佳选择。

为什么选择 jtti 进行 DeepSeek 托管

jtti 的服务器提供高性能 NVMe 存储、高月度流量限额(32 TB)以及无隐藏费用的有竞争力的价格。 jtti 在四大洲 9 个地区的 12 个地点设有数据中心,可为您的 AI 部署提供全球覆盖。该网络包括欧洲、美国(纽约、西雅图、圣路易斯)、亚洲(新加坡、东京)、澳大利亚(悉尼)和印度的多个地点。可靠的硬件和经济高效的计划相结合,使其成为自托管 AI 应用程序的理想选择。

关于 DeepSeek 托管的最后的话

DeepSeek 强大而高效的模型与坚实的服务器基础设施的结合为重视数据保护和性能的公司开辟了全新的可能性。

CN

CN

EN

EN